THE.Hosting расширяет свою глобальную инфраструктуру — Австралия становится нашей новой точкой присутствия. Открыт предзаказ на виртуальные серверы со скоростью портов до 10 Гбит/с, размещаемые в дата-центре на континенте. Австралия — это не только стратегически важный регион с высокими стандартами интернет-услуг, но и возможность масштабировать ваши проекты с минимальной задержкой для пользователей в Океании и Юго-Восточной Азии.

THE.Hosting расширяет свою глобальную инфраструктуру — Австралия становится нашей новой точкой присутствия. Открыт предзаказ на виртуальные серверы со скоростью портов до 10 Гбит/с, размещаемые в дата-центре на континенте. Австралия — это не только стратегически важный регион с высокими стандартами интернет-услуг, но и возможность масштабировать ваши проекты с минимальной задержкой для пользователей в Океании и Юго-Восточной Азии.  Специальное предложение До 15 августа 2025 года, 23:59 (UTC+3), вы можете получить скидку 50% при оформлении предзаказа. Просто введите промокод AUSTRALIA50 в корзине под суммой заказа. Все предварительно заказанные серверы будут активированы сразу после окончания 96-часового отсчета. Скидка действительна только до указанной даты — после этого промокод аннулируется. Начните расширять свою ИТ-инфраструктуру с надежным партнером — THE.Hosting. https://the.hosting...

Специальное предложение До 15 августа 2025 года, 23:59 (UTC+3), вы можете получить скидку 50% при оформлении предзаказа. Просто введите промокод AUSTRALIA50 в корзине под суммой заказа. Все предварительно заказанные серверы будут активированы сразу после окончания 96-часового отсчета. Скидка действительна только до указанной даты — после этого промокод аннулируется. Начните расширять свою ИТ-инфраструктуру с надежным партнером — THE.Hosting. https://the.hosting...

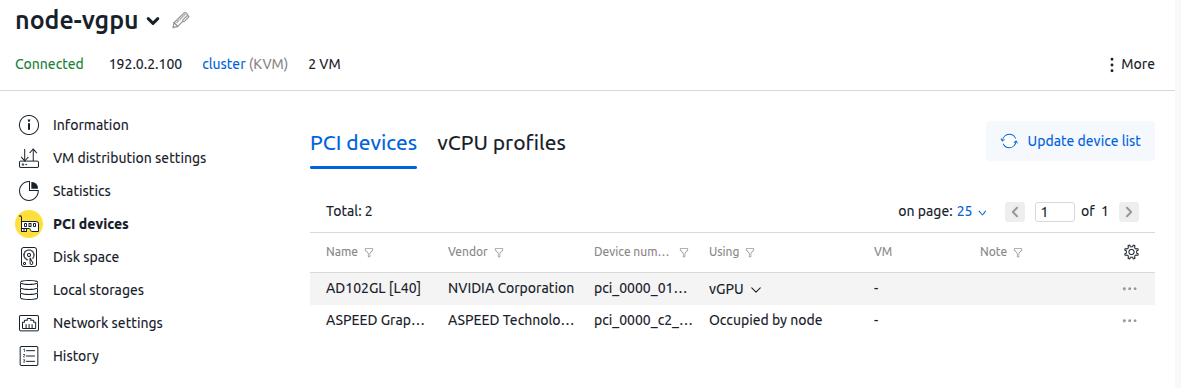

Поддержка технологии vGPU Мы добавили возможность подключать из интерфейса платформы графические ускорители в режиме vGPU. Данная технология позволяет разделять физический графический процессор (GPU) на несколько виртуальных, каждый из которых может быть выделен отдельной виртуальной машине. Так, один физический GPU может обслуживать несколько пользователей или задач. Технология vGPU применяется в таких сценариях, как VDI, машинное обучение, искусственный интеллект, рендеринг, гейминг и стриминг. www.ispsystem.com/docs/vmmanager-admin/clusters/using-vgpu

Поддержка технологии vGPU Мы добавили возможность подключать из интерфейса платформы графические ускорители в режиме vGPU. Данная технология позволяет разделять физический графический процессор (GPU) на несколько виртуальных, каждый из которых может быть выделен отдельной виртуальной машине. Так, один физический GPU может обслуживать несколько пользователей или задач. Технология vGPU применяется в таких сценариях, как VDI, машинное обучение, искусственный интеллект, рендеринг, гейминг и стриминг. www.ispsystem.com/docs/vmmanager-admin/clusters/using-vgpu

Отображение статистики в ЛК клиента Мы переработали интерфейс работы со статистикой в ЛК клиента. Теперь пользователям доступно 2 режима работы: Потребление по дням – режим сохранил все предыдущие возможности; в него не вносились доработки.Перерасход по месяцам – новый режим позволяет просматривать данные ретроспективно за выбранный отчетный период для каждого аддона по статистике в услуге. При этом на графике добавлено пороговое значение, а также блоки слева, отображающие информацию по аддону (лимит, потребление, превышение). Справа добавлена сводная информация, отображающая стоимость перерасхода в периоде. Кроме этого, мы добавили в ЛК клиента и ЛК администратора новый раздел “Ресурсы по статистике”. В ЛК клиента раздел отображает список услуг с дополнениями по статистике и их состоянию (нормальное состояние, приближение к перерасходу, перерасход), а также дополнения в текущем периоде. В ЛК администратора в данный раздел попадают услуги при приближении к перерасходу и при перерасходе – для аналитики со стороны администратора. Улучшение поведения зависимостей в тарифах Мы улучшили возможности настройки поведения списков значений на странице заказа услуги. Теперь при выборе опции в Глобальных настройках «не отображать недоступные для заказа значения» недоступные значения не будут видны. В случае выбора опции «отображать недоступные для заказа значения» (выбрана по умолчанию) недоступные значения подсвечиваются красным...

Отображение статистики в ЛК клиента Мы переработали интерфейс работы со статистикой в ЛК клиента. Теперь пользователям доступно 2 режима работы: Потребление по дням – режим сохранил все предыдущие возможности; в него не вносились доработки.Перерасход по месяцам – новый режим позволяет просматривать данные ретроспективно за выбранный отчетный период для каждого аддона по статистике в услуге. При этом на графике добавлено пороговое значение, а также блоки слева, отображающие информацию по аддону (лимит, потребление, превышение). Справа добавлена сводная информация, отображающая стоимость перерасхода в периоде. Кроме этого, мы добавили в ЛК клиента и ЛК администратора новый раздел “Ресурсы по статистике”. В ЛК клиента раздел отображает список услуг с дополнениями по статистике и их состоянию (нормальное состояние, приближение к перерасходу, перерасход), а также дополнения в текущем периоде. В ЛК администратора в данный раздел попадают услуги при приближении к перерасходу и при перерасходе – для аналитики со стороны администратора. Улучшение поведения зависимостей в тарифах Мы улучшили возможности настройки поведения списков значений на странице заказа услуги. Теперь при выборе опции в Глобальных настройках «не отображать недоступные для заказа значения» недоступные значения не будут видны. В случае выбора опции «отображать недоступные для заказа значения» (выбрана по умолчанию) недоступные значения подсвечиваются красным...

Благодарим вас за вашу постоянную поддержку name.com. Мы хотим сообщить вам о важном изменении правил регистрации доменов ICANN, которое может повлиять на данные о владельце вашего домена. В феврале 2024 года ICANN представила новую Политику регистрационных данных, которая изменяет порядок обработки контактных данных и прав собственности на домены, особенно для доменов без кода страны (не ccTLD). Что такое ccTLD? Что меняется? Начиная с 21 августа 2025 года новая Политика ICANN в отношении регистрационных данных меняет порядок определения права собственности на домен. В настоящее время: имя и фамилия регистранта определяют право собственности на домен. С 21 августа 2025 года: если поле «Организация» в контактной информации регистранта заполнено, эта организация будет считаться законным владельцем домена. Имя и фамилия будут считаться контактной информацией, а не владельцем.Дальнейшие действия: Если вы не хотите, чтобы организация считалась владельцем домена, войдите в свою учетную запись name.com или обратитесь к своему провайдеру домена, чтобы обновить контактную информацию о домене.Дальнейшие действия: Если вы не хотите, чтобы организация считалась владельцем домена, войдите в свою учетную запись name.com или обратитесь к своему провайдеру домена, чтобы обновить контактную информацию о домене.Если вы не знаете, как обновить свою учетную запись или доменное имя в учетной записи name.com, ознакомьтесь со следующими статьями поддержки: Обновление учетной записи или Обновление домена. Изменения в типах контактов домена В этой политике также обновляется порядок обработки типов контактов доменов и требования реестров: В настоящее время для доменов отображаются 4 типа контактов: регистрант, администратор, технический специалист и ответственный за выставление счетов. Будут собираться и храниться только необходимые контактные данные, определенные реестром домена верхнего уровня (обычно это только регистрант). Любая неиспользованная контактная информация будет удалена из нашей системы. Конфиденциальность домена Как всегда, если вы предпочитаете, чтобы ваши контактные данные не были публично видны в службах каталогов регистрационных данных (WHOIS/RDAP), мы рекомендуем включить расширенную безопасность для вашего домена. Давайте убедимся, что все в порядке Мы рекомендуем вам проверить контактную информацию вашего домена уже сейчас, чтобы убедиться в ее точности, прежде чем политика вступит в силу 21 августа 2025 года.Проверьте и обновите контактную информацию вашего регистранта.Проверьте поле «Организация» — если оно неверно или не нужно, удалите его.Это обновление распространяется на всех регистраторов, аккредитованных ICANN, и является частью более широкого изменения политики в масштабах всей отрасли...

Август — месяц низких цен на по-настоящему мощное железо. Мы собрали список лучших предложений выделенных серверов в Нидерландах, которые отлично подходят под задачи, требующие высокой скорости и производительности. Все они по самым выгодным ценам! Ловите момент — акция действует только до конца августа! Выберите подходящую конфигурацию под амбиции вашего проекта: 2x Xeon E5-2620v4 Promo 16 ядер, 32 потока (до 3.00 GHz) 64 GB RAM и 2 x 960 GB Enterprise SSD Канал 1 Gbit/s (100 TB трафика) Начальная конфигурация в нашей подборке, но достаточно мощная для того, чтобы закрыть потребности многих web-приложений и не только. Заказать за 74 EUR в месяц! AMD EPYC 7402P Promo 24 ядра, 48 потоков (до 3,35 GHz) 64 GB RAM и Hardware RAID 1 (480 GB Enterprise SSD x 2) Канал 1 Gbit/s (100 TB трафика) Конфигурация полюбившаяся многим клиентам. Мощный процессор, производительные Enterprise SSD в зеркальном Hardware RAID массиве. Надёжный и быстрый сервер подходящий для любого проекта. Заказать за 108 EUR в месяц прямо сейчас! AMD EPYC 7402P Promo 128 GB 24 ядра, 48 потоков (до 3,35 GHz) 128 GB RAM и Hardware RAID 1 (960 GB Enterprise SSD x 2) Канал 1 Gbit/s (100 TB трафика) Аналогичная конфигурация, но с ещё большим количеством ресурсов, для ещё более требовательных задач. Заказать за 146 EUR в месяц! 2x Xeon Gold 6230R Promo 52 ядра, 104 потока (до 4.00 GHz) 128 GB RAM и 2 x 960 GB Enterprise NVMe SSD Канал 1 Gbit/s (100 TB трафика) Более 100 вычислительных потоков вкупе с высокопроизводительными NVMe дисками — настоящая мощность, подходящая для high-load проектов, виртуализации, сложного машинного обучения. Супер-цена: 297 EUR в месяц! В погоне за высокой производительностью не забываем и о базовых вещах. Конфигурация, позволяющая организовать собственный сервер резервного копирования, файлообменник, не требовательный проект и не только: Xeon E3-1230v6 Promo 4 ядра, 8 потоков (до 3.90 GHz) 16 GB RAM и 1 TB HDD Канал 1 Gbit/s (50 TB трафика) Всего 34 EUR в месяц! Преимущества выделенных серверов в Нидерландах от EuroHoster: Дата-центр с низкой латентностью по Европе;Базовая защита от DDoS-атак до 40 Gbit/s;Полный root-доступ, DNS, возможность заказа мониторинга;Скидки до -15% при оплате на 3-12 месяцев вперёд. Акция действует до конца августа! Напиши нам прямо сейчас и уже завтра ты можешь получить свой новый мощный выделенный сервер! Большинство выделенных серверов выдаются в течении 24 часов с момента заказа в будние дни...

Август — месяц низких цен на по-настоящему мощное железо. Мы собрали список лучших предложений выделенных серверов в Нидерландах, которые отлично подходят под задачи, требующие высокой скорости и производительности. Все они по самым выгодным ценам! Ловите момент — акция действует только до конца августа! Выберите подходящую конфигурацию под амбиции вашего проекта: 2x Xeon E5-2620v4 Promo 16 ядер, 32 потока (до 3.00 GHz) 64 GB RAM и 2 x 960 GB Enterprise SSD Канал 1 Gbit/s (100 TB трафика) Начальная конфигурация в нашей подборке, но достаточно мощная для того, чтобы закрыть потребности многих web-приложений и не только. Заказать за 74 EUR в месяц! AMD EPYC 7402P Promo 24 ядра, 48 потоков (до 3,35 GHz) 64 GB RAM и Hardware RAID 1 (480 GB Enterprise SSD x 2) Канал 1 Gbit/s (100 TB трафика) Конфигурация полюбившаяся многим клиентам. Мощный процессор, производительные Enterprise SSD в зеркальном Hardware RAID массиве. Надёжный и быстрый сервер подходящий для любого проекта. Заказать за 108 EUR в месяц прямо сейчас! AMD EPYC 7402P Promo 128 GB 24 ядра, 48 потоков (до 3,35 GHz) 128 GB RAM и Hardware RAID 1 (960 GB Enterprise SSD x 2) Канал 1 Gbit/s (100 TB трафика) Аналогичная конфигурация, но с ещё большим количеством ресурсов, для ещё более требовательных задач. Заказать за 146 EUR в месяц! 2x Xeon Gold 6230R Promo 52 ядра, 104 потока (до 4.00 GHz) 128 GB RAM и 2 x 960 GB Enterprise NVMe SSD Канал 1 Gbit/s (100 TB трафика) Более 100 вычислительных потоков вкупе с высокопроизводительными NVMe дисками — настоящая мощность, подходящая для high-load проектов, виртуализации, сложного машинного обучения. Супер-цена: 297 EUR в месяц! В погоне за высокой производительностью не забываем и о базовых вещах. Конфигурация, позволяющая организовать собственный сервер резервного копирования, файлообменник, не требовательный проект и не только: Xeon E3-1230v6 Promo 4 ядра, 8 потоков (до 3.90 GHz) 16 GB RAM и 1 TB HDD Канал 1 Gbit/s (50 TB трафика) Всего 34 EUR в месяц! Преимущества выделенных серверов в Нидерландах от EuroHoster: Дата-центр с низкой латентностью по Европе;Базовая защита от DDoS-атак до 40 Gbit/s;Полный root-доступ, DNS, возможность заказа мониторинга;Скидки до -15% при оплате на 3-12 месяцев вперёд. Акция действует до конца августа! Напиши нам прямо сейчас и уже завтра ты можешь получить свой новый мощный выделенный сервер! Большинство выделенных серверов выдаются в течении 24 часов с момента заказа в будние дни...

Мы заметили, что SMS-сообщения часто не доходят из-за технических особенностей операторов связи. Чтобы вы всегда оставались на связи и получали важные уведомления вовремя, рекомендуем подключить Telegram. Почему Telegram? Надежная доставка сообщений;Мгновенные уведомления;Никакой рекламы и спама! Как подключиться? Перейдите в настройки учётной записи на вкладку «Соц. сети».Нажмите на значок Телеграма На сайте telegram.org подтвердите подключение к нашему боту;На странице уведомлений и безопасности настройте уведомления в Телеграм.Также рекомендуем выключить 2ФА по SMS и настроить TOTP аутентификацию. Если у вас возникнут вопросы, будем рады помочь!...

Мы заметили, что SMS-сообщения часто не доходят из-за технических особенностей операторов связи. Чтобы вы всегда оставались на связи и получали важные уведомления вовремя, рекомендуем подключить Telegram. Почему Telegram? Надежная доставка сообщений;Мгновенные уведомления;Никакой рекламы и спама! Как подключиться? Перейдите в настройки учётной записи на вкладку «Соц. сети».Нажмите на значок Телеграма На сайте telegram.org подтвердите подключение к нашему боту;На странице уведомлений и безопасности настройте уведомления в Телеграм.Также рекомендуем выключить 2ФА по SMS и настроить TOTP аутентификацию. Если у вас возникнут вопросы, будем рады помочь!...

11 августа оператор связи Citytelecom и сеть дата-центров Datahouse (входят в периметр ГК ФИЛАНКО) подверглись скоординированной хакерской атаке, направленной на ядро сетевой инфраструктуры компаний. Атака началась в ночь на 11 августа, ориентировочно в 01:00 по московскому времени. Дежурные службы Citytelecom автоматически зафиксировали сбой в работе сети, инженеры оперативно приступили к диагностике. В результате кибератаки была повреждена конфигурация главного магистрального маршрутизатора сети передачи данных. Для выяснения причин команда действовала поэтапно, проверяя каждый сегмент сети. По мере восстановления контроля была выявлена сохранность ключевых данных и критически важных серверов. Первичный анализ характера атаки исключил использование DDoS-технологий. Благодаря слаженной работе профильных подразделений, повышенному вниманию к системам кибербезопасности и регулярному совершенствованию защиты инфраструктуры большинство сервисов было восстановлено уже к вечеру. «Инженерные ИТ-подразделения любой компании постоянно готовятся к возможным атакам, совершенствуя свои системы защиты. К сожалению, злоумышленникам иногда удается добиться сбоев в системах. Что касается произошедшего инцидента, тщательная предварительная подготовка, наличие резервных копий, а также сегментированная система защиты позволила нашей команде оперативно локализовать проблему и восстановить большую часть инфраструктуры. Особую благодарность хотим выразить коллегам из отраслевого сообщества, которые предложили свою помощь и экспертизу для ликвидации последствий хакерского воздействия», — Алексей Солдатов, генеральный директор ГК Филанко. В настоящее время все силы компании направлены на устранение повреждений и возобновление работы ряда клиентов. Следующим шагом станет детальный анализ разработки дополнительных мер по усилению системы безопасности. Кибератака не затронула инфраструктуру ЦОД. Компания подтверждает, что данные клиентов, хранящиеся в ЦОД, находятся в безопасности и не попали к третьим лицам...

11 августа оператор связи Citytelecom и сеть дата-центров Datahouse (входят в периметр ГК ФИЛАНКО) подверглись скоординированной хакерской атаке, направленной на ядро сетевой инфраструктуры компаний. Атака началась в ночь на 11 августа, ориентировочно в 01:00 по московскому времени. Дежурные службы Citytelecom автоматически зафиксировали сбой в работе сети, инженеры оперативно приступили к диагностике. В результате кибератаки была повреждена конфигурация главного магистрального маршрутизатора сети передачи данных. Для выяснения причин команда действовала поэтапно, проверяя каждый сегмент сети. По мере восстановления контроля была выявлена сохранность ключевых данных и критически важных серверов. Первичный анализ характера атаки исключил использование DDoS-технологий. Благодаря слаженной работе профильных подразделений, повышенному вниманию к системам кибербезопасности и регулярному совершенствованию защиты инфраструктуры большинство сервисов было восстановлено уже к вечеру. «Инженерные ИТ-подразделения любой компании постоянно готовятся к возможным атакам, совершенствуя свои системы защиты. К сожалению, злоумышленникам иногда удается добиться сбоев в системах. Что касается произошедшего инцидента, тщательная предварительная подготовка, наличие резервных копий, а также сегментированная система защиты позволила нашей команде оперативно локализовать проблему и восстановить большую часть инфраструктуры. Особую благодарность хотим выразить коллегам из отраслевого сообщества, которые предложили свою помощь и экспертизу для ликвидации последствий хакерского воздействия», — Алексей Солдатов, генеральный директор ГК Филанко. В настоящее время все силы компании направлены на устранение повреждений и возобновление работы ряда клиентов. Следующим шагом станет детальный анализ разработки дополнительных мер по усилению системы безопасности. Кибератака не затронула инфраструктуру ЦОД. Компания подтверждает, что данные клиентов, хранящиеся в ЦОД, находятся в безопасности и не попали к третьим лицам...

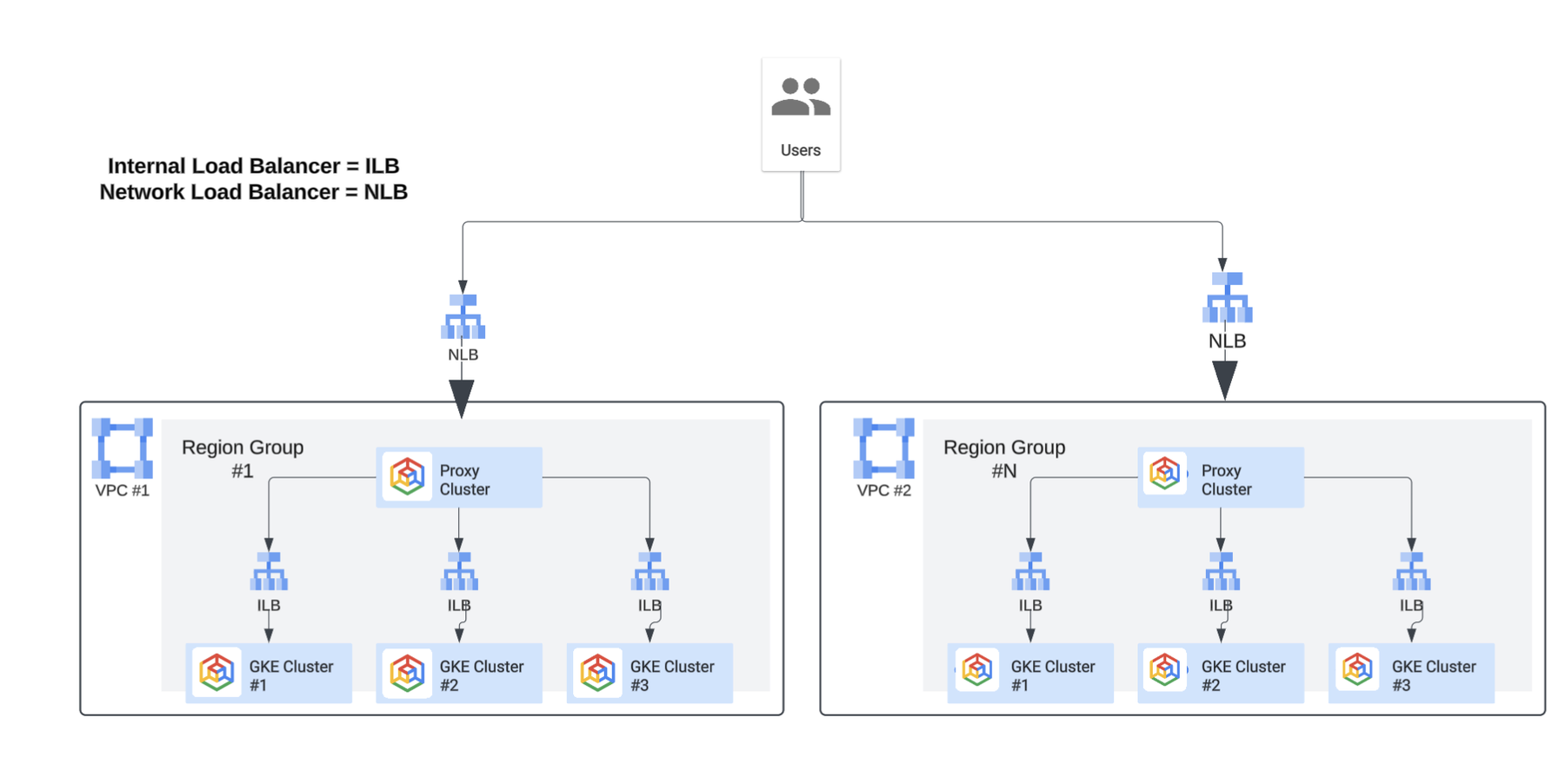

Yahoo находится в самом разгаре многолетнего процесса миграции своего знаменитого приложения Yahoo Mail в Google Cloud. В приложении задействовано более 100 сервисов и компонентов промежуточного ПО, поэтому Yahoo Mail в первую очередь использует подход «переноса и переноса» для своей локальной инфраструктуры, стратегически трансформируя и перенастраивая ключевые компоненты и промежуточное ПО для использования возможностей облачной инфраструктуры. Чтобы обеспечить успешную миграцию, команды Google и Yahoo Mail активно сотрудничали, собирая информацию о текущей архитектуре и принимая решения относительно границ проекта, сетевой архитектуры и настройки кластеров Google Kubernetes Engine (GKE). Эти решения были критически важны ввиду глобального характера приложения, которое должно быть высокодоступным и избыточным для обеспечения бесперебойной работы пользователей по всему миру. По мере того, как Yahoo Mail продвигается к миграции первой волны рабочих нагрузок в производственную среду, мы выделяем ключевые элементы архитектуры, в частности, многопользовательскую платформу GKE, которая сыграла ключевую роль в создании прочной основы для миграции. Благодаря многопользовательской поддержке приложение Yahoo Mail может эффективно работать в Google Cloud, помогая удовлетворять разнообразные требования различных арендаторов приложений. Процесс проектирования Организация Google по предоставлению профессиональных услуг (PSO) начала процесс проектирования с детального анализа текущего использования системы и требований к емкости. Это включало проведение бенчмарков, сбор исходных данных о существующих рабочих нагрузках и оценку необходимого количества узлов на основе типов машин, которые наилучшим образом соответствовали бы требованиям к производительности и ресурсам для этих рабочих нагрузок. Одновременно мы обсуждали оптимальное количество кластеров GKE и их типы, а также наилучшее размещение и организацию рабочих нагрузок в кластерах. Другим аспектом процесса проектирования было определение количества сред (помимо производственной среды). Мы стремились найти баланс между сложностью эксплуатации, ростом зависимости от локальных сервисов при развёртывании и снижением потенциальных рисков, связанных с дефектами и ошибками приложений. Но прежде чем принимать решения о кластерах GKE, нам необходимо было определить количество проектов и VPC. На эти решения влияли различные факторы, включая требования заказчика к рабочей нагрузке и масштабируемости, а также ограничения сервисов и квот Google Cloud. В то же время мы хотели минимизировать эксплуатационные расходы. Анализ количества кластеров GKE, VPC и т.д. был довольно простым: достаточно было задокументировать плюсы и минусы каждого подхода. Тем не менее, мы тщательно следовали обширному процессу, учитывая значительное и далеко идущее влияние этих решений на общую архитектуру. Мы использовали несколько критериев для определения необходимого количества кластеров GKE и организации рабочих нагрузок в них. Основными характеристиками, которые мы учитывали, были требования к потреблению ресурсов различными рабочими нагрузками, схемы межсервисного взаимодействия и баланс между эксплуатационной эффективностью и минимизацией радиуса воздействия сбоя. Архитектурная схема Ниже представлено упрощенное представление текущей архитектуры. Основная архитектура состоит из четырёх кластеров GKE на каждую группу регионов (например, в регионах «Восток США» — один VPC) и на каждую среду. Архитектура охватывает несколько регионов, обеспечивая отказоустойчивость и высокую доступность на уровне сервисов. Существует четыре группы регионов, и, следовательно, четыре VPC. Внешний пользовательский трафик направляется в ближайший регион с помощью политики геолокации, настроенной в публичных зонах Cloud DNS. Внутри трафик маршрутизируется между группами регионов через прокси-приложение, а трафик между кластерами GKE — через внутренний балансировщик нагрузки (ILB), где каждый ILB имеет собственную запись DNS.

Yahoo находится в самом разгаре многолетнего процесса миграции своего знаменитого приложения Yahoo Mail в Google Cloud. В приложении задействовано более 100 сервисов и компонентов промежуточного ПО, поэтому Yahoo Mail в первую очередь использует подход «переноса и переноса» для своей локальной инфраструктуры, стратегически трансформируя и перенастраивая ключевые компоненты и промежуточное ПО для использования возможностей облачной инфраструктуры. Чтобы обеспечить успешную миграцию, команды Google и Yahoo Mail активно сотрудничали, собирая информацию о текущей архитектуре и принимая решения относительно границ проекта, сетевой архитектуры и настройки кластеров Google Kubernetes Engine (GKE). Эти решения были критически важны ввиду глобального характера приложения, которое должно быть высокодоступным и избыточным для обеспечения бесперебойной работы пользователей по всему миру. По мере того, как Yahoo Mail продвигается к миграции первой волны рабочих нагрузок в производственную среду, мы выделяем ключевые элементы архитектуры, в частности, многопользовательскую платформу GKE, которая сыграла ключевую роль в создании прочной основы для миграции. Благодаря многопользовательской поддержке приложение Yahoo Mail может эффективно работать в Google Cloud, помогая удовлетворять разнообразные требования различных арендаторов приложений. Процесс проектирования Организация Google по предоставлению профессиональных услуг (PSO) начала процесс проектирования с детального анализа текущего использования системы и требований к емкости. Это включало проведение бенчмарков, сбор исходных данных о существующих рабочих нагрузках и оценку необходимого количества узлов на основе типов машин, которые наилучшим образом соответствовали бы требованиям к производительности и ресурсам для этих рабочих нагрузок. Одновременно мы обсуждали оптимальное количество кластеров GKE и их типы, а также наилучшее размещение и организацию рабочих нагрузок в кластерах. Другим аспектом процесса проектирования было определение количества сред (помимо производственной среды). Мы стремились найти баланс между сложностью эксплуатации, ростом зависимости от локальных сервисов при развёртывании и снижением потенциальных рисков, связанных с дефектами и ошибками приложений. Но прежде чем принимать решения о кластерах GKE, нам необходимо было определить количество проектов и VPC. На эти решения влияли различные факторы, включая требования заказчика к рабочей нагрузке и масштабируемости, а также ограничения сервисов и квот Google Cloud. В то же время мы хотели минимизировать эксплуатационные расходы. Анализ количества кластеров GKE, VPC и т.д. был довольно простым: достаточно было задокументировать плюсы и минусы каждого подхода. Тем не менее, мы тщательно следовали обширному процессу, учитывая значительное и далеко идущее влияние этих решений на общую архитектуру. Мы использовали несколько критериев для определения необходимого количества кластеров GKE и организации рабочих нагрузок в них. Основными характеристиками, которые мы учитывали, были требования к потреблению ресурсов различными рабочими нагрузками, схемы межсервисного взаимодействия и баланс между эксплуатационной эффективностью и минимизацией радиуса воздействия сбоя. Архитектурная схема Ниже представлено упрощенное представление текущей архитектуры. Основная архитектура состоит из четырёх кластеров GKE на каждую группу регионов (например, в регионах «Восток США» — один VPC) и на каждую среду. Архитектура охватывает несколько регионов, обеспечивая отказоустойчивость и высокую доступность на уровне сервисов. Существует четыре группы регионов, и, следовательно, четыре VPC. Внешний пользовательский трафик направляется в ближайший регион с помощью политики геолокации, настроенной в публичных зонах Cloud DNS. Внутри трафик маршрутизируется между группами регионов через прокси-приложение, а трафик между кластерами GKE — через внутренний балансировщик нагрузки (ILB), где каждый ILB имеет собственную запись DNS.  Характеристики многопользовательской платформы GKE Как указано в общедоступной документации Google, при запуске и эксплуатации кластера GKE необходимо учитывать ряд факторов. Команда платформы усердно работала над решением следующих вопросов и удовлетворением требований различных команд арендаторов: Размещение рабочей нагрузки: команда платформы назначает метки пулам узлов для поддержки соответствия рабочей нагрузки, а арендаторы используют комбинацию маркеров и допусков, чтобы гарантировать распределение рабочих нагрузок по правильным пулам узлов. Это необходимо, поскольку каждый пул узлов предъявляет особые требования к межсетевому экрану в зависимости от типа обрабатываемого трафика (HTTPS, POPS и т.д.). Кроме того, теги диспетчера ресурсов используются для управления правилами межсетевого экрана и связывания пула узлов с соответствующим правилом межсетевого экрана.Управление доступом: управление доступом на основе ролей (RBAC) в Kubernetes — основной способ управления и ограничения доступа пользователей к ресурсам кластера. У каждого арендатора есть одно или несколько пространств имён в кластере, и кластер загружается со стандартными политиками в процессе подключения арендатора.Сетевые политики: все кластеры организованы на основе dataplane v2, а Yahoo Mail использует стандартную сетевую политику Kubernetes для управления потоками трафика. В основе лежит Cilium — решение с открытым исходным кодом для обеспечения, защиты и мониторинга сетевого соединения между рабочими нагрузками.Квоты ресурсов: для оптимизации использования ресурсов и предотвращения чрезмерного потребления команда платформы применяет квоты ресурсов для ЦП/памяти в пределах пространства имен.Масштабирование: определяется командой платформы на основе запросов квот, поданных арендатором при подключении. Из-за определённых ограничений функций, связанных с автоматической подготовкой узлов, связанных с использованием безопасных тегов для правил брандмауэра и определением определённого типа и формы машины, это не удалось реализовать, но мы совместно с командой инженеров разработали запросы функций для устранения этого пробела. Проблемы В ходе этой миграции как Yahoo Mail, так и Google столкнулись с техническими ограничениями и проблемами. Ниже мы описываем некоторые из основных проблем и подходы, принятые для их решения: Подключение к плоскости управления: Как и большинство корпоративных клиентов, Yahoo Mail предоставила частные кластеры GKE и нуждалась в подключении между плоскостью управления и инструментом CI/CD (отвёрткой) извне сети VPC. Команда платформы развернула хосты-бастионы, которые использовались для проксирования подключения к плоскости управления, но столкнулась с проблемами масштабируемости. Google совместно с клиентом протестировала два решения, использующие шлюз Connect и конечную точку на основе DNS, чтобы исключить необходимость в хосте-бастионе.Сквозной mTLS: одним из ключевых принципов безопасности Yahoo Mail было обеспечение сквозного mTLS, который должен быть реализован как в архитектуре в целом, так и в базовых сервисах Google Cloud. Это привело к серьёзным проблемам, поскольку один из ключевых продуктов балансировки нагрузки ( Application Load Balancer ) на тот момент не поддерживал сквозной mTLS. Мы исследовали альтернативные решения, такие как внедрение специализированного прокси-приложения и использование балансировщиков нагрузки уровня 4 во всём стеке. Профессиональные сервисы также сотрудничали с инженерами Google Cloud для определения требований к поддержке mTLS в рамках Application Load Balancer.Интеграция с Athenz: Yahoo Mail использовала внутренний инструмент управления идентификацией и доступом Athenz, с которым должны были интегрироваться все сервисы Google Cloud для реализации федерации идентификационных данных рабочей нагрузки. В контексте Kubernetes это означало, что пользователям по-прежнему требовалась аутентификация через Athenz, но федерация идентификационных данных рабочей нагрузки использовалась в качестве посредника. Поскольку федерация идентификационных данных рабочей нагрузки также была относительно новой функцией, для успешного внедрения в среду Yahoo Mail нам потребовалось тесное сотрудничество с инженерами Google Cloud.Kubernetes externalTrafficPolicy: Одной из отличительных функций, о которой Yahoo Mail горячо и с нетерпением рассуждала, была взвешенная маршрутизация для балансировщиков нагрузки. Эта функция позволяла оптимально направлять входящий трафик к бэкендам. Хотя эта функция поддерживалась для управляемых групп экземпляров, на тот момент встроенной интеграции с GKE не было. В связи с её отсутствием команде платформы пришлось исследовать и экспериментировать с режимами externalTrafficPolicy, такими как локальный и кластерный режимы, чтобы определить влияние на производительность и ограничения.Планирование ресурсов: Наконец, что не менее важно, специалисты Google Professional Services выполнили планирование ресурсов – краеугольный камень успешной миграции в облако. В данном случае это включало в себя совместную работу нескольких команд разработчиков приложений для определения базового уровня потребностей в ресурсах, формирования ключевых предположений и оценки ресурсов, необходимых для удовлетворения текущих и будущих потребностей. Планирование ресурсов – это высоко итеративный процесс, который должен меняться по мере изменения рабочих нагрузок и требований. Поэтому регулярные проверки и поддержание четкой коммуникации с Google имели первостепенное значение для обеспечения адаптации поставщика облачных услуг к потребностям клиента. Следующая веха Yahoo Mail Миграция такого большого приложения, как Yahoo Mail, — это сложнейшая задача. Благодаря двуединому подходу — «поднятию и переносу» для большинства сервисов и стратегической перестройке архитектуры для некоторых — Yahoo уверенно движется к настройке своей почтовой системы для следующего поколения клиентов. Хотя небольшая часть системы Yahoo Mail уже находится в эксплуатации, ожидается, что большинство её сервисов будут запущены в течение следующего года. Подробнее о том, как Google PSO может помочь с другими аналогичными сервисами, см. на этой странице. cloud.google.com/consulting/portfolio...

Характеристики многопользовательской платформы GKE Как указано в общедоступной документации Google, при запуске и эксплуатации кластера GKE необходимо учитывать ряд факторов. Команда платформы усердно работала над решением следующих вопросов и удовлетворением требований различных команд арендаторов: Размещение рабочей нагрузки: команда платформы назначает метки пулам узлов для поддержки соответствия рабочей нагрузки, а арендаторы используют комбинацию маркеров и допусков, чтобы гарантировать распределение рабочих нагрузок по правильным пулам узлов. Это необходимо, поскольку каждый пул узлов предъявляет особые требования к межсетевому экрану в зависимости от типа обрабатываемого трафика (HTTPS, POPS и т.д.). Кроме того, теги диспетчера ресурсов используются для управления правилами межсетевого экрана и связывания пула узлов с соответствующим правилом межсетевого экрана.Управление доступом: управление доступом на основе ролей (RBAC) в Kubernetes — основной способ управления и ограничения доступа пользователей к ресурсам кластера. У каждого арендатора есть одно или несколько пространств имён в кластере, и кластер загружается со стандартными политиками в процессе подключения арендатора.Сетевые политики: все кластеры организованы на основе dataplane v2, а Yahoo Mail использует стандартную сетевую политику Kubernetes для управления потоками трафика. В основе лежит Cilium — решение с открытым исходным кодом для обеспечения, защиты и мониторинга сетевого соединения между рабочими нагрузками.Квоты ресурсов: для оптимизации использования ресурсов и предотвращения чрезмерного потребления команда платформы применяет квоты ресурсов для ЦП/памяти в пределах пространства имен.Масштабирование: определяется командой платформы на основе запросов квот, поданных арендатором при подключении. Из-за определённых ограничений функций, связанных с автоматической подготовкой узлов, связанных с использованием безопасных тегов для правил брандмауэра и определением определённого типа и формы машины, это не удалось реализовать, но мы совместно с командой инженеров разработали запросы функций для устранения этого пробела. Проблемы В ходе этой миграции как Yahoo Mail, так и Google столкнулись с техническими ограничениями и проблемами. Ниже мы описываем некоторые из основных проблем и подходы, принятые для их решения: Подключение к плоскости управления: Как и большинство корпоративных клиентов, Yahoo Mail предоставила частные кластеры GKE и нуждалась в подключении между плоскостью управления и инструментом CI/CD (отвёрткой) извне сети VPC. Команда платформы развернула хосты-бастионы, которые использовались для проксирования подключения к плоскости управления, но столкнулась с проблемами масштабируемости. Google совместно с клиентом протестировала два решения, использующие шлюз Connect и конечную точку на основе DNS, чтобы исключить необходимость в хосте-бастионе.Сквозной mTLS: одним из ключевых принципов безопасности Yahoo Mail было обеспечение сквозного mTLS, который должен быть реализован как в архитектуре в целом, так и в базовых сервисах Google Cloud. Это привело к серьёзным проблемам, поскольку один из ключевых продуктов балансировки нагрузки ( Application Load Balancer ) на тот момент не поддерживал сквозной mTLS. Мы исследовали альтернативные решения, такие как внедрение специализированного прокси-приложения и использование балансировщиков нагрузки уровня 4 во всём стеке. Профессиональные сервисы также сотрудничали с инженерами Google Cloud для определения требований к поддержке mTLS в рамках Application Load Balancer.Интеграция с Athenz: Yahoo Mail использовала внутренний инструмент управления идентификацией и доступом Athenz, с которым должны были интегрироваться все сервисы Google Cloud для реализации федерации идентификационных данных рабочей нагрузки. В контексте Kubernetes это означало, что пользователям по-прежнему требовалась аутентификация через Athenz, но федерация идентификационных данных рабочей нагрузки использовалась в качестве посредника. Поскольку федерация идентификационных данных рабочей нагрузки также была относительно новой функцией, для успешного внедрения в среду Yahoo Mail нам потребовалось тесное сотрудничество с инженерами Google Cloud.Kubernetes externalTrafficPolicy: Одной из отличительных функций, о которой Yahoo Mail горячо и с нетерпением рассуждала, была взвешенная маршрутизация для балансировщиков нагрузки. Эта функция позволяла оптимально направлять входящий трафик к бэкендам. Хотя эта функция поддерживалась для управляемых групп экземпляров, на тот момент встроенной интеграции с GKE не было. В связи с её отсутствием команде платформы пришлось исследовать и экспериментировать с режимами externalTrafficPolicy, такими как локальный и кластерный режимы, чтобы определить влияние на производительность и ограничения.Планирование ресурсов: Наконец, что не менее важно, специалисты Google Professional Services выполнили планирование ресурсов – краеугольный камень успешной миграции в облако. В данном случае это включало в себя совместную работу нескольких команд разработчиков приложений для определения базового уровня потребностей в ресурсах, формирования ключевых предположений и оценки ресурсов, необходимых для удовлетворения текущих и будущих потребностей. Планирование ресурсов – это высоко итеративный процесс, который должен меняться по мере изменения рабочих нагрузок и требований. Поэтому регулярные проверки и поддержание четкой коммуникации с Google имели первостепенное значение для обеспечения адаптации поставщика облачных услуг к потребностям клиента. Следующая веха Yahoo Mail Миграция такого большого приложения, как Yahoo Mail, — это сложнейшая задача. Благодаря двуединому подходу — «поднятию и переносу» для большинства сервисов и стратегической перестройке архитектуры для некоторых — Yahoo уверенно движется к настройке своей почтовой системы для следующего поколения клиентов. Хотя небольшая часть системы Yahoo Mail уже находится в эксплуатации, ожидается, что большинство её сервисов будут запущены в течение следующего года. Подробнее о том, как Google PSO может помочь с другими аналогичными сервисами, см. на этой странице. cloud.google.com/consulting/portfolio...